HAFTUNGSAUSSCHLUSS: Dieser Artikel ist älter als ein Jahr und möglicherweise nicht mit den neuesten Ereignissen oder neu verfügbaren Informationen auf dem neuesten Stand.

Sonali Desai, Produkt Marketing Managerin, VMware

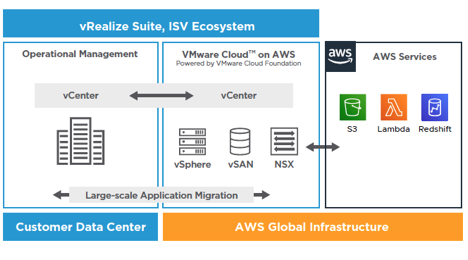

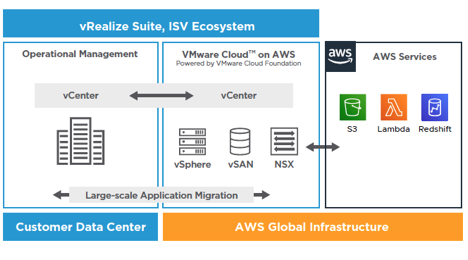

Mit einer Rechenzentrumserweiterung können VMware Cloud on AWS-Nutzer ihre On-Premises-Infrastruktur in die Cloud ausweiten, um schwankende Kapazitätsanforderungen abzudecken. Der letzte Teil dieser dreiteiligen Blog-Serie widmet sich häufigen Herausforderungen und deren Bewältigung.

Im ersten Blog-Beitrag dieser Serie wurden VMware Cloud on AWS und die wichtigsten kundenorientierten Anwendungsbereiche vorgestellt. Im zweiten Blog-Beitrag dieser Serie wurden Anwendungsbereiche für die Cloud-Migration im Detail erläutert. Im dritten Teil dieser Serie wird der zweite Anwendungsbereich näher erläutert: Rechenzentrumserweiterung: – die Erweiterung Ihrer On-Premises-Infrastruktur in die Cloud mit VMware Cloud on AWS.

Es gibt verschiedene Szenarien, die Kunden zu einer Erweiterung in die Cloud veranlassen können, z.B.:

- Es besteht ein geografischer Kapazitätsbedarf (z.B. Richtlinien zur Datensouveränität oder Notwendigkeit einer geringeren Entfernung zu Anwendern) und Kunden möchten nicht in den Aufbau eines neuen Rechenzentrums investieren.

- Es ist nicht genügend On-Premises-Kapazität für saisonale Bedarfsspitzen vorhanden.

- Kunden benötigen ungeplante, temporäre Kapazität oder Kapazität für neue Projekte und möchten nicht in Overprovisioning oder den Aufbau neuer On-Premises-Kapazität investieren.

- Kunden möchten On-Premises-Desktop-Services einfach ohne zusätzliche Hardware ergänzen und erweitern.

- Kunden entwickeln neue Anwendungen, die in On-Premises-Anwendungen integriert werden oder auf native Cloud-Services zugreifen müssen.

- Es müssen Test- und Entwicklungsaktivitäten in einer Cloud-Umgebung durchgeführt werden, die mit On-Premises-Umgebungen vergleichbar ist.

Wenn Kunden jedoch ihre bestehende On-Premises-Umgebung in die Cloud erweitern, müssen sie viele Herausforderungen bewältigen.

Typische Herausforderungen bei einer Erweiterung der On-Premises-Umgebung in die Cloud:

- Interoperabilität zwischen den Umgebungen: Bei der Migration in die Cloud ist eine Architekturänderung/Refactoring, eine Konvertierung der Maschinenformate usw. erforderlich.

- Inkompatible Kenntnisse, Tools und Prozesse: Infrastruktur- und Operations-Teams müssen sich neue Kenntnisse und Tools aneignen sowie vorhandene Prozesse anpassen, um die Vorteile einer Public Cloud-Integration voll auszuschöpfen.

- Management unterschiedlicher Infrastrukturen: Inkonsistente Managementtools, die in On-Premises- und Cloud-Umgebungen isoliert ausgeführt werden

- Kostspielige und komplexe bidirektionale Anwendungsmobilität: Sobald sich Anwendungen in der Public Cloud befinden, ist es nahezu unmöglich, sie zurück in die On-Premises-Umgebung zu holen. Dazu ist ein hoher Arbeitsaufwand notwendig, der die Migration äußerst kostspielig und zeitaufwendig gestaltet.

- Inkonsistente Sicherheit und Governance: Aufgrund der unterschiedlichen Infrastruktur von On-Premises- und Public Cloud-Umgebungen können vorhandene Sicherheits- und Governance-Verfahren sowie -Tools nur begrenzt weiterverwendet werden.

VMware Cloud on AWS löst diese Herausforderungen folgendermaßen:

- VMware Cloud on AWS erweitert Ihre On-Premises-Infrastruktur auf die Cloud – mit demselben vSphere Hypervisor, auf dem bereits Millionen von Workloads ausgeführt werden. Der Service wird im Rahmen einer dedizierten Bare-Metal-EC2(Elastic Compute Cloud)-Instanz in der AWS Cloud angeboten. Dadurch ist bei der Anwendungsmigration keine Umstrukturierung erforderlich. So werden Kosten, Zeitaufwand sowie Komplexität reduziert und Sie profitieren von spielend einfachen bidirektionalen Migrationen.

- Mit VMware Cloud on AWS können Kunden vertraute, bewährte VMware-Kenntnisse, -Tools und -Prozesse in der Cloud nutzen. Damit entfällt der Erwerb neuer Kenntnisse oder Tools.

- VMware vCenter ist ein weitverbreitetes, bewährtes Managementtool, mit dem Infrastrukturadministratoren weltweit vSphere-basierte On-Premises-Infrastrukturen betreiben. Es dient als Managementtool für VMware Cloud on AWS und bietet vCenter-Administratoren konsistenten Betrieb.

- Da Anwendungen für die VMware Cloud on AWS-Migration nicht umstrukturiert werden müssen, sinken Kosten, Zeitaufwand und Komplexität und Sie profitieren von nahtlosen bidirektionalen Migrationen.

- Mit VMware Cloud on AWS können Kunden ihre aktuellen On-Premises-Richtlinien für Sicherheit und Governance auf die Cloud ausweiten.

Als Nächstes werden die verschiedenen Funktionen und Merkmale des Services für eine nahtlose Erweiterung Ihrer On-Premises-Umgebung auf die Cloud erläutert:

- Hybrid Linked Mode:

- Dieser Modus bietet eine zentrale Oberfläche für das Management von On-Premises- und Cloud-Ressourcen über die vCenter-Instanz Ihres VMware Cloud on AWS-SDDC. Dadurch erzielen Sie betriebliche Konsistenz und Transparenz für beide Umgebungen.

- Mit dem Hybrid Linked Mode können Sie die vCenter Server-Instanzen von VMware Cloud on AWS und einer On-Premises-Umgebung miteinander verbinden.

- Wenn Sie Ihre vCenter Server-Instanz in der Cloud mit einer Domäne verbinden, die mehrere im Rahmen des erweiterten verknüpften Modus verbundene vCenter Server-Instanzen enthält, werden alle diese Instanzen mit Ihrem Cloud-SDDC verknüpft.

- Mit dem Hybrid Linked Mode können Sie

- sich mit Ihren On-Premises-Anmeldedaten bei der vCenter Server-Instanz in Ihrem SDDC anmelden,

- den Bestand Ihres On-Premises- und Cloud-SDDC über eine zentrale vSphere Client-Oberfläche anzeigen und verwalten,

- Workloads direkt über die UI mittels Kaltmigration und vMotion zwischen Ihrem On-Premises-Rechenzentrum und dem Cloud-SDDC verschieben.

- vCenter Cloud Gateway:

- vCenter Cloud Gateway ist eine Appliance, die Sie herunterladen und On-Premises installieren können, um die vCenter-Instanzen Ihrer On-Premises- und Cloud-Umgebungen miteinander zu verbinden.

- Sie tritt der On-Premises-Single Sign-On(SSO)-Domäne bei, wodurch Sie den Hybrid Linked Mode für das Management von Hybridressourcen über Ihr On-Premises-Rechenzentrum konfigurieren können.

- vCenter Cloud Gateway enthält die vSphere-UI-Oberfläche, mit der Kunden die vCenter Server-Instanzen ihrer On-Premises- und VMware Cloud on AWS-Umgebungen verwalten können. Die vCenter Cloud Gateway-Erfahrung entspricht exakt der Hybrid Linked Mode-Erfahrung in VMware Cloud on AWS. Der einzige Unterschied besteht darin, dass die Ausführung lokal in Ihrer On-Premises-Umgebung erfolgt.

- Ressourcen: Link zur Dokumentation, Zugehörige Blog-Beiträge

- vCenter-Inhaltsbibliothek:

- Die vCenter-Inhaltsbibliothek ist die perfekte Funktion, um Vorlagen, OVAs, ISO-Images und Skripts zwischen SDDC-Bereitstellungen On-Premises und in der Cloud zu synchronisieren.

- Sie können VMTX-OVF-Vorlagen bereitstellen, klonen und synchronisieren, ISOs mounten und sogar Gastanpassungen vornehmen.

- Mit der Inhaltsbibliothek können Sie das Potenzial von VMware Cloud on AWS bereits ab dem ersten Tag vollständig ausschöpfen.

- Ressourcen: Link zur Dokumentation, Betriebsleitfaden: Verwenden einer Inhaltsbibliothek

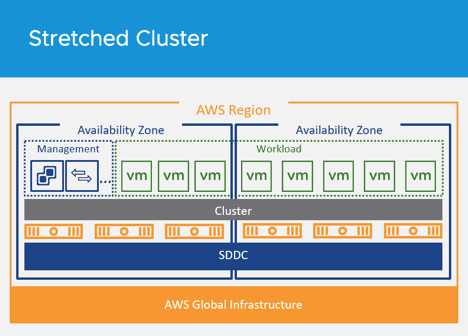

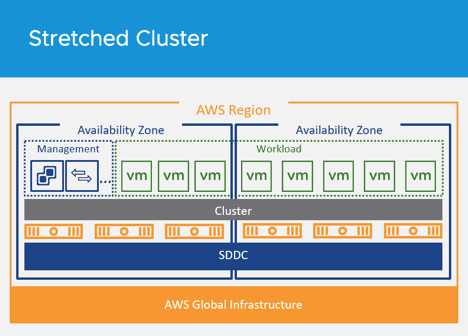

- Stretched Cluster:

- Standard-Cluster befinden sich bei VMware Cloud on AWS in einer einzigen Amazon-Region und Availability Zone (AZ). Somit wären Cluster bei einem Ausfall einer Amazon-AZ nicht mehr verfügbar.

- Für Workloads, bei denen ein potenzieller AZ-Ausfall nicht zu tolerieren ist, können Kunden einen Stretched Cluster bereitstellen.

- Stretched Cluster schützen VMware Cloud on AWS-Infrastrukturen auf Infrastrukturebene vor dem Ausfall von AWS-AZs. Die Ausweitung eines SDDC-Clusters über zwei AWS-AZs innerhalb einer Region bedeutet, dass ein AZ-Ausfall einfach als vSphere HA-Ereignis behandelt wird und virtuelle Maschinen in einer anderen AZ neu gestartet werden. So wird eine Infrastrukturverfügbarkeit von 99,99% erreicht.

- Anwendungen können sich innerhalb eines VMware Cloud on AWS-Clusters nun über mehrere AWS Availability Zones erstrecken.

- Zu den wesentlichen Vorteilen von Stretched Clustern zählt Folgendes:

- Zero RPO-Hochverfügbarkeit für mit vSphere virtualisierte Unternehmensanwendungen über AWS Availability Zones (AZ) hinweg (Stretched Clustering über mehrere Availability Zones)

- Durch Stretched Cluster können sich Entwickler verstärkt auf wichtige Anwendungsanforderungen und -funktionen konzentrieren, anstatt sich mit der Infrastrukturverfügbarkeit auseinanderzusetzen.

- Die Verfügbarkeit Ihrer Anwendungen wird erheblich verbessert, ohne dass diese in Ihre Anwendung integriert werden muss.

- Elastic DRS:

- Mit Elastic DRS können Sie Richtlinien zur automatischen Skalierung Ihres Cloud-SDDC festlegen. Je nach Bedarf fügen Sie dabei Hosts hinzu oder entfernen diese.

- Elastic DRS verwendet einen Algorithmus, der die optimale Anzahl bereitgestellter Hosts beibehält, um Cluster auszulasten und gleichzeitig die gewünschte CPU-, Arbeitsspeicher- und Storage-Performance zu erzielen.

- Es wird entweder eine Rück- oder horizontale Skalierung von Clustern empfohlen. Bei horizontalen Skalierungsempfehlungen veranlasst ein Entscheidungsmodul die Bereitstellung eines neuen Hosts im Cluster. Bei einer Rückskalierungsempfehlung wird der am wenigsten ausgelastete Host aus dem Cluster entfernt.

- Diese Funktion wird auf Cluster-Ebene aktiviert. Das Überwachungsintervall beträgt fünf Minuten.

- Die horizontale Skalierung ist standardmäßig nur für Storage aktiviert. Die Funktion kann manuell für maximale Performance und/oder möglichst niedrige Kosten optimiert werden.

- Sie können eDRS mittels Richtlinie oder RESTful-APIs aktivieren, um die Konfiguration dieser Richtlinie zu automatisieren.

- Ressourcen: Link zur Dokumentation, Zugehörige Blog-Beiträge, Blog-Beitrag zu Elastic DRS mit RESTful-APIs

- Automatische Erweiterung/Verkleinerung des Cloud-SDDC nach Bedarf:

- Einer der größten Vorteile von VMware Cloud on AWS besteht darin, Hosts und Cluster schnell und einfach zu Ihrem SDDC hinzuzufügen oder zu entfernen.

- Hinzufügen von Hosts:

- Durch das Hinzufügen von Hosts zu Ihrem SDDC steigern Sie die verfügbare Computing- und Storage-Kapazität Ihres SDDC. Sie können maximal bis zu 16 Hosts pro Cluster und 20 Cluster pro SDDC hinzufügen.

- Hosts werden aus dem Serverpool von AWS bereitgestellt. ESXi (einschließlich jedes einzelnen VMkernel und logischen Netzwerks) wird gestartet, vollständig konfiguriert und anschließend zu Ihrer vCenter-Instanz oder Ihrem SDDC hinzugefügt. Der gesamte Vorgang dauert etwa 10 bis 15 Minuten.

- Nachdem Hosts mit dem Netzwerk verbunden und zum Cluster hinzugefügt wurden, wird der vSAN-Datastore automatisch erweitert. Anschließend kann der Cluster die neue Storage-Kapazität nutzen und mit der Synchronisierung von vSAN-Objekten beginnen.

- Sie können Hosts aus Ihrem SDDC entfernen, solange Sie die Mindestanforderung von drei Hosts in Ihrem SDDC-Cluster erfüllen.

- Sie können Cluster zu einem Cloud-SDDC hinzufügen, bis Sie das Konfigurationsmaximum Ihres Kontos erreicht haben. Zusätzliche Cluster werden in derselben Availability Zone des ursprünglichen SDDC erstellt.

- Die von Ihnen für das SDDC erstellten logischen Netzwerke werden automatisch von allen Clustern verwendet. Computing- und Storage-Ressourcen werden gleichermaßen für alle Cluster konfiguriert.

- Sie können bis auf den ersten Cluster (Cluster-1) beliebige Cluster aus einem SDDC entfernen.

- Wenn Sie einen Cluster löschen, werden alle Workload-VMs des Clusters sofort beendet und alle Daten und Konfigurationsinformationen gelöscht. Sie verlieren den API- und UI-Zugriff auf den Cluster. Die mit VMs des Clusters verbundenen öffentlichen IP-Adressen werden freigegeben.

- Richtlinienverwaltung:

- In VMware Cloud on AWS können Sie Computing-Richtlinien definieren und damit festlegen, wie VMs von vSphere Distributed Resource Scheduler (DRS) auf den Hosts eines Ressourcenpools platziert werden sollen.

- Aktuell können Sie fünf verschiedene Arten von Richtlinien festlegen:

- VM-Host-Affinitätsrichtlinie

- Mit einer VM-Host-Affinitätsrichtlinie wird eine Affinitätsbeziehung zwischen einer Kategorie von virtuellen Maschinen und einer Kategorie von Hosts hergestellt.

- Solche Richtlinien können nützlich sein, wenn VMs mit bestimmten Anwendungen im Rahmen der hostbasierten Lizenzierung auf Hosts platziert werden müssen, die für diese Anwendungen lizenziert sind.

- Sie sind außerdem nützlich, wenn virtuelle Maschinen mit workloadspezifischen Konfigurationen auf Hosts mit bestimmten Eigenschaften platziert werden müssen.

- VM-Host-Anti-Affinitätsrichtlinie:

- Mit einer VM-Host-Anti-Affinitätsrichtlinie wird eine Anti-Affinitätsbeziehung zwischen einer Gruppe von VMs und einer Gruppe von Hosts hergestellt.

- So kann verhindert werden, dass unkritische Workloads auf Hosts mit ressourcenintensiven Anwendungen ausgeführt werden. Dadurch vermeiden Sie Ressourcenkonflikte.

- VM-VM-Affinitätsrichtlinie:

- Mit einer VM-VM-Affinitätsrichtlinie wird eine Affinitätsbeziehung zwischen VMs hergestellt.

- Diese Richtlinie ist nützlich, wenn zwei oder mehr VMs von der Platzierung auf demselben Host profitieren, um Latenzen möglichst gering zu halten.

- VM-VM-Anti-Affinitätsrichtlinie:

- Eine VM-VM-Anti-Affinitätsrichtlinie beschreibt eine Beziehung innerhalb einer Kategorie von VMs.

- Eine VM-VM-Anti-Affinitätsrichtlinie verhindert die Platzierung virtueller Maschinen derselben Kategorie auf demselben Host.

- Diese Richtlinie kann nützlich sein, wenn Sie virtuelle Maschinen mit kritischen Workloads auf separaten Hosts platzieren möchten, sodass der Ausfall eines Hosts keine Auswirkungen auf die anderen VMs dieser Kategorie hat.

- Richtlinie zur Deaktivierung von DRS vMotion:

- Mit einer Richtlinie zur Deaktivierung von DRS vMotion wird verhindert, dass VMs auf einen anderen Host migriert werden, sofern der aktuelle Host nicht ausgefallen ist oder in den Wartungsmodus versetzt wurde.

- Diese Art von Richtlinie kann für VMs mit Anwendungen nützlich sein, die Ressourcen auf dem lokalen Host erstellen und diese lokal nutzen müssen. Falls VMs von DRS zum Lastausgleich oder aufgrund von Reservierungsanforderungen auf einen anderen Host verschoben werden, bleiben die von Anwendungen erstellten Ressourcen zurück. Die Beeinträchtigung der Referenzlokalität kann sich negativ auf die Performance auswirken.

- Diese Richtlinie wird aktiv, sobald eine gekennzeichnete VM eingeschaltet wird. Die Richtlinie stellt sicher, dass die VM auf ihrem derzeitigen Host verbleibt, solange dieser verfügbar ist. Die Richtlinie hat keinen Einfluss auf die Entscheidung, auf welchem Host eine VM eingeschaltet wird.

- Ressourcen: Link zur Dokumentation, Zugehörige Blog-Beiträge

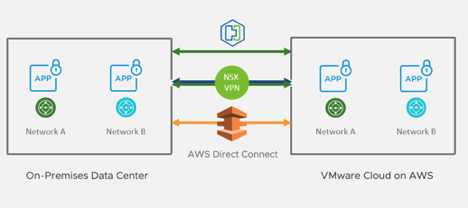

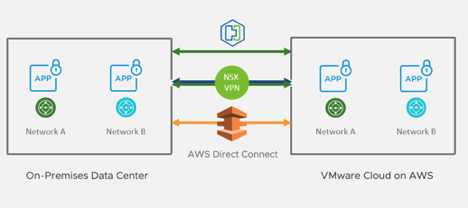

- Verschiedene Interkonnektivitätsoptionen:

– Mit der Konfiguration eines IPsec-VPN erhalten Sie eine sichere Verbindung zu Ihrem SDDC. Unterstützt werden routen- und richtlinienbasierte VPNs. Beide VPN-Arten verbinden sich über das Internet mit dem SDDC. Ein routenbasiertes VPN kann sich außerdem über AWS Direct Connect mit dem SDDC verbinden.

– Die L2VPN-Funktion von VMware Cloud on AWS unterstützt die Erweiterung von VLAN-Netzwerken. Die L2VPN-Verbindung mit dem NSX-T-Server verwendet einen IPsec-Tunnel. Das erweiterte L2VPN-Netzwerk erweitert VM-Netzwerke und überträgt nur Workload-Datenverkehr. Es ist unabhängig von den VMkernel-Netzwerken, die für den Migrationsdatenverkehr (ESXi-Management oder vMotion) verwendet werden. Diese nutzen entweder ein separates IPsec-VPN oder eine Direct Connect-Verbindung

– Ein einziges L2VPN auf dem Computing-Gateway kann bis zu 100 On-Premises-Netzwerke erweitern. Der L2VPN-Server in Ihrem Cloud-SDDC wird von VMware Cloud on AWS mittels NSX-T bereitgestellt. L2VPN-Client-Funktionen können von einer eigenständigen NSX Edge-Instanz zur Verfügung gestellt werden, die Sie herunterladen und in Ihrem On-Premises-Rechenzentrum bereitstellen.

– Durch Abstrahierung Ihrer Infrastruktur und die Nutzung verschiedener vSphere-Versionen und Netzwerktypen werden leistungsstarke, standortübergreifende Interkonnektivitätsfunktionen bereitgestellt.

– Außerdem können Sie ein WAN-optimiertes, standortübergreifendes IPsec-VPN-Netz für sichere Konnektivität zwischen Standorten einrichten.

– Weiten Sie Layer 2-Netzwerke und Rechenzentren auf mehrere Standorte aus.

– Führen Sie Workload-Massen- und bidirektionale vMotion-Live-Migrationen unter Beibehaltung von MAC- und IP-Adressen durch.

- Verwendung von AWS Direct Connect:

– AWS Direct Connect ist ein von AWS bereitgestellter Service, über den Sie eine Verbindung mit hoher Geschwindigkeit und geringer Latenz zwischen Ihrem On-Premises-Rechenzentrum und AWS-Services herstellen können.

– Direct Connect-Datenverkehr wird über ein oder mehrere virtuelle Schnittstellen übertragen, die Sie in Ihrem AWS-Kundenkonto erstellen. Bei SDDCs, in denen Networking-Funktionen von NSX-T bereitgestellt werden, nutzt der gesamte Direct Connect-Datenverkehr (einschließlich vMotion-, Management- und Computing-Gateway-Datenverkehr) eine private virtuelle Schnittstelle. Dadurch wird eine private Verbindung zwischen Ihrem On-Premises-Rechenzentrum und einer einzigen Amazon VPC eingerichtet.

Ressourcen:

- Ausführliches Webinar zur Rechenzentrumserweiterung: In diesem Webinar werden die technischen Funktionen und Merkmale von VMware Cloud on AWS zur Erweiterung Ihrer On-Premises-Umgebung in die Cloud im Detail behandelt.

- Lösungsübersicht für die Rechenzentrumserweiterung (noch offen)

Hier sind einige weitere Schulungsressourcen für VMware Cloud on AWS:

Bleiben Sie mit den VMware Cloud on AWS-Versionshinweisen stets auf dem Laufenden.

Sie möchten bei VMware immer up to date sein? Dann folgen Sie VMware auf Twitter, XING, LinkedIn & Youtube

Kategorie: Neuigkeiten & Highlights

Schlagwörter: AWS, cloud, SDDC, vmware

Keine Kommentare bisher